Google war einmal eine Suchmaschine, auf die sich Nutzer wie Webseitenbetreiber verlassen konnten. Ein halbwegs neutraler Index des Webs, der die relevantesten Inhalte nach oben spülte und damit kleinen wie großen Projekten eine faire Chance gab. Für viele Seitenbetreiber war die Einbindung von Google‑Werbung eine einfache Möglichkeit, die eigenen Inhalte zu finanzieren. Und YouTube, der scheinbar kreative Ableger, machte es möglich, aus Videos ein Auskommen zu erzielen. Dieses Bild gehört der Vergangenheit an.

Werbung frisst die Suche

Längst dominieren bezahlte Anzeigen die Ergebnisseite. Wer nicht zahlt, steht hinten an – egal wie gut oder relevant der Inhalt ist. Suchanfragen werden mit Werbebannern zugekleistert oder mit Treffern gefüllt, die sich Unternehmen durch hohe Budgets gesichert haben. Nutzer müssen immer weiter nach unten scrollen, um organische Treffer zu finden, und schenken den Werbeanzeigen trotzdem häufig Beachtung. So verkommt der ehemals neutrale Dienst zu einer Verkaufsplattform.

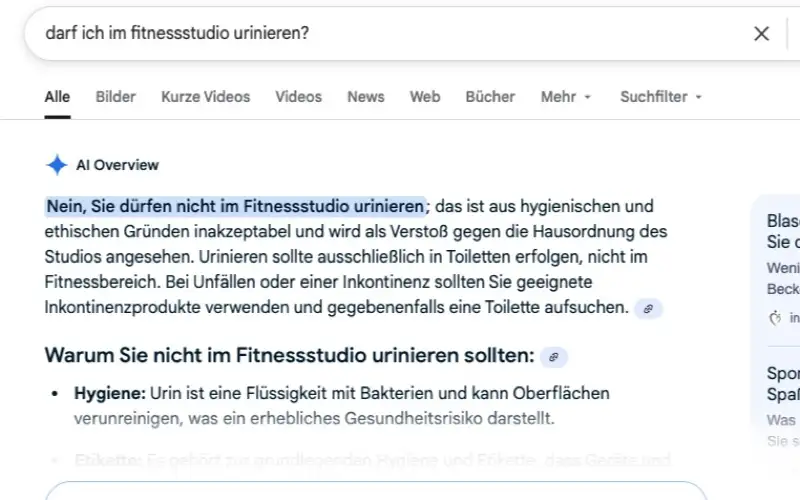

KI‑Antworten kappen den Traffic

Mit dem Sprung auf den KI‑Zug geht Google noch einen Schritt weiter. Anstatt die gefundenen Seiten zu verlinken, serviert Google eine von einer künstlichen Intelligenz zusammengebaute Antwort als oberstes Ergebnis. Diese Antwort basiert auf Inhalten, die andere erstellt haben – aus Texten von Bloggern, Journalisten und Fachautoren. Da die Nutzer ihre Antwort bereits direkt unterhalb des Suchfelds erhalten, klicken sie seltener auf die verlinkten Seiten. Die Folge: Der Traffic auf unabhängigen Webseiten bricht ein, Werbeeinnahmen sinken, und die Motivation, neue Inhalte zu produzieren, schwindet.

Kreative Arbeit ohne Gegenleistung

Bei dieser Praxis wird geistiges Eigentum abgesaugt. Artikel, Tutorials, Erfahrungsberichte und Fachtexte werden von der KI in Sekundenschnelle analysiert und neu kombiniert. Die ursprünglichen Autoren werden weder genannt noch entlohnt. Was bleibt, ist das Gefühl, für eine gigantische Maschine zu arbeiten, die sich mit fremden Federn schmückt. Für alle, die über Jahre hinweg Wissen und Erfahrung investiert haben, ist das eine Ohrfeige.

Dieses Problem reicht jedoch tiefer als ein bloßes Unbehagen: Juristinnen und Informatiker, die im Auftrag der Initiative Urheberrecht ein Gutachten zum Training generativer KI‑Modelle erstellt haben, kommen zu dem Schluss, dass die Verwendung geschützter Texte und Bilder keine Bagatelle ist. Sie stellen fest, dass das Training solcher Modelle nicht als erlaubtes Text‑ und Data‑Mining betrachtet werden kann, sondern als Urheberrechtsverletzung1. Das Gutachten weist darauf hin, dass generative Systeme Teile ihrer Trainingsdaten speichern und diese mit passenden Prompts reproduzieren können. Es gibt also Mechanismen, die eine „eins‑zu‑eins“-Vervielfältigung ermöglichen, obwohl die Modelle offiziell keine Speicherfunktion haben. Die Forscher betonen zudem, dass die betroffenen Kreativen keinerlei Vergütung erhalten, obwohl sich am Horizont ein „ertragreicher Lizenzmarkt“ abzeichnet. Vielmehr droht ihnen, von genau den Technologien verdrängt zu werden, die ihr Material auswerten.

Die negativen Folgen sind bereits konkret sichtbar. Große Medienhäuser wie die New York Times verklagen KI‑Entwickler wegen millionenfacher Urheberrechtsverstöße und beklagen, dass ihre journalistische Arbeit kopiert wird, ohne dass es dafür Kompensationen gibt2. Hinzu kommt ein wirtschaftlicher Schaden: Die Zeitung platziert in ihren Online‑Texten Affiliate‑Links und verdient an jedem Klick. Wenn Nutzerinnen und Nutzer die Inhalte aber über ChatGPT konsumieren und nicht mehr auf die Originalseiten gehen, entgehen dem Verlag diese Einnahmen; der Konzern spricht von Schäden in Milliardenhöhe.

Die Praxis trifft nicht nur große Verlage. Autorinnen, Blogger, Fotografen und Videoproduzenten investieren Zeit, Geld und Herzblut in ihre Werke. Wenn generative KI diese Werke ohne Genehmigung in ihre Modelle einspeist und daraus neue Texte, Bilder oder Videos erstellt, profitieren letztlich nur die Plattformbetreiber und Hersteller der KI. Für die Kreativen bleibt das frustrierende Gefühl, für eine Maschine zu arbeiten, die sich mit fremden Federn schmückt. Ohne einen fairen Ausgleich droht eine Abwärtsspirale: Wer nicht mehr von seiner Arbeit leben kann, wird weniger investieren. Im schlimmsten Fall verarmen qualitativ hochwertige Inhalte, und automatisierte Massenware dominiert.

Die Debatte zeigt, dass die technologischen Möglichkeiten der KI dringend mit klaren rechtlichen Regeln einhergehen müssen. Um menschliche Kreativität zu schützen und die Vielfalt im Netz zu erhalten, braucht es verbindliche Lizenzmodelle und eine gerechte Vergütung.

Mangelnde Transparenz und Abhängigkeit

Gleichzeitig wächst die Abhängigkeit der Nutzer von diesem einen Konzern. Google kontrolliert sowohl die Werkzeuge zur Veröffentlichung (YouTube, Blogger, Ads) als auch die Kanäle der Distribution (Suche, News, Empfehlungen). Die Algorithmen hinter den Suchergebnissen sind undurchsichtig, Änderungen werden selten kommuniziert, und Einbrüche im Ranking können über das Schicksal ganzer Unternehmen entscheiden. Wer sich dem System entziehen will, findet kaum Alternativen mit ähnlicher Reichweite.

Unfair wird es, wenn Google die von ihm abhängigen Creators zusätzlich mit schlechten Nachrichten unter Druck setzt. YouTube-Filmemacher erhalten regelmäßig Hinweise, dass ihre Abrufzahlen zurückgehen oder dass ein Video „unterdurchschnittlich performt“. Statt transparenter Ursachenforschung gibt es allgemeine Ratschläge wie „häufiger hochladen“ oder „im Thumbnail lächeln“, die von vielen als lächerlich empfunden werden. Auch Webseitenbetreiber werden über die Suchkonsole mit Warnungen zu sinkenden Besucherzahlen und mahnenden Empfehlungen zur Verbesserung bombardiert, während ihnen gleichzeitig durch KI-Antworten Traffic entzogen wird. So entsteht der Eindruck, dass der Konzern einerseits die Reichweite beschneidet und andererseits diejenigen, die davon leben, zu immer mehr Arbeit und Inhalten antreibt, ohne ihnen eine verlässliche Perspektive zu bieten.

Bedrohung für Vielfalt und Qualität

Wenn sich hochwertige Inhalte finanziell nicht mehr lohnen, werden sie seltener entstehen. Stattdessen wächst der Anteil an Klick‑Ködern, automatisierten Texten und oberflächlichen Beiträgen, die auf Werbeeinblendungen optimiert sind. Die Vielfalt unabhängiger Stimmen im Netz nimmt ab, große Portale und Plattformen dominieren, und die Informationsqualität sinkt. Zudem besteht die Gefahr, dass KI‑generierte Antworten Fehler oder Verzerrungen enthalten, die sich schnell verbreiten, weil sie wie offizielle Wahrheiten wirken.

Brutale existenzielle Folgen

Sinkende Besucherzahlen und wegbrechende Werbeeinnahmen sind für viele Seitenbetreiber existenzbedrohend. Wenn Google den Nutzern fertige Antworten präsentiert, bleiben die Klicks auf weiterführende Links aus. Weniger Klicks bedeuten weniger Sichtbarkeit, weniger Zeit, die Besucher auf den Seiten verbringen, und damit deutlich weniger Werbeeinblendungen. Für Websites, die von Anzeigen leben, bedeutet das einen schleichenden Einnahmeverlust. Ohne diese Mittel fehlt es am Budget für Recherche, Redaktion und technische Wartung. Viele kleinere Portale geraten in die Zwickmühle. Einzelkämpfer wie ich denken vermehrt darüber nach, komplett aufzuhören.

Wenn Google keine Besucher mehr schickt, wofür macht man das dann noch?

Aber auch größere Anbieter leiden heftig: Sie müssen Kürzungen vornehmen, Personal entlassen oder hinter Bezahlschranken verschwinden. Die Vielfalt der Informationsangebote schrumpft, und die Qualität der Berichterstattung leidet. Was als Nebeneffekt der KI‑Integration beginnt, hat das Potenzial, die unabhängige Medienlandschaft nachhaltig zu schädigen.

KIs im Kreisverkehr: Wenn sich die Maschine selbst füttert

Was vor wenigen Jahren noch wie ein Science‑Fiction‑Plot klang, ist heute Alltag: Große Nachrichtenportale lassen ihre Artikel von künstlicher Intelligenz erstellen. Beim US‑Techmagazin CNET flog 2023 auf, dass mehr als 70 Finanzbeiträge mit ChatGPT verfasst wurden, versteckt hinter dem harmlosen Autorenkürzel „CNET Money Staff“3. Unter dem Deckmantel eines „Experiments“ ersetzte man ganze Redakteure – und versprach dann, fortan wenigstens offen auszuweisen, wenn ein Beitrag aus dem Automaten stammt. Bei der Mediengruppe Gannett, zu der USA Today gehört, schreibt inzwischen ein System namens Espresso „polierte Artikel“ aus Gemeindemeldungen; lokale Redaktionen wie MetroWest Daily News und Wicked Local schmücken KI‑Texte mit menschlichen Namen und weisen nur in kleinen Fußnoten darauf hin, dass KI beteiligt war4. Auch Bankrate und andere Finanzportale nutzen automatisierte Texte für Suchmaschinen‑Optimierung. Im Ergebnis entstehen Unmengen von Beiträgen, die Menschen lesen sollen, die aber nie ein Mensch geschrieben hat.

Der Witz dabei: Je mehr dieser KI‑Artikel das Netz fluten, desto häufiger landen sie wieder dort, woher sie kommen – in den Trainingssets der nächsten Modelle. Studien warnen vor „Modell‑Kollaps“: Wenn generative KI mit ihren eigenen Ausgaben gefüttert wird, entsteht ein selbstverstärkender Feedback‑Loop, der die Qualität immer weiter verschlechtert5. Forschende vergleichen das mit einem Foto, das man immer wieder abfotografiert und ausdruckt: Jede Kopie enthält neue Fehler, bis am Ende nur noch bunte Flecken übrig bleiben. Denn die großen Sprachmodelle leben vom menschlichen Rohstoff im Netz; ist der knapp, bleibt nur noch synthetische Suppe übrig. Das US‑Magazin The Week spricht von „AI‑Kannibalisierung“: Mangels frischer Daten trainieren die Entwickler ihre Bots mit Daten, die andere Bots produziert haben – und wundern sich, wenn die Antworten zunehmend wirrer werden6. So droht aus dem Internet ein endloses Spiel stille Post zu werden, bei dem Maschinen ihre eigenen Gerüchte flüstern, bis niemand mehr versteht, worum es ging.

Das Absurde nimmt derweil Fahrt auf. Eine Analyse der „AI slop“ genannten KI‑Schlieren im Netz zeigt, dass neun der hundert am schnellsten wachsenden YouTube‑Kanäle rein computergenerierte Inhalte wie Zombie‑Fußball und Katzen‑Seifenopern senden, während alteingesessene Sci‑Fi‑Magazine wie Clarkesworld ihre Türen für Einsendungen schließen mussten, weil sie in KI‑Müll ertrinken7. Selbst Wikipedia ächzt unter der Last automatisch erzeugter Einträge. Die Folge ist eine Informationslandschaft, in der KIs Artikel lesen, die von KIs geschrieben wurden, um sie wiederum in Antworten zu verwandeln, die KIs demnächst als Quelle dienen. Man kann sich ausmalen, wie das endet: Auf die Frage nach „Compound Interest“ bekommt man eine Abhandlung über blau‑, rot‑ und gelbschwänzige Jackrabbits, weil ein Sprachmodell versehentlich eine synthetische Datenlawine losgetreten hat. Es ist fast zum Lachen – oder zum Weinen – wie schnell die Maschine beginnt, ihre eigenen Federn zu rupfen.

Fazit

Google hat sich von einer hilfreichen Suchmaschine zu einem schwerfälligen, selbstzufriedenen Konglomerat entwickelt, das den offenen Austausch im Web eher hemmt als fördert. Werbung, bezahlte Rankings und KI‑Antworten untergraben die Auffindbarkeit und Monetarisierung unabhängiger Inhalte. Die langfristigen Folgen könnten gravierend sein: weniger Vielfalt, sinkende Qualität und eine verstärkte Abhängigkeit von wenigen Anbietern. Es wäre höchste Zeit, dass Nutzer, Content‑Ersteller und Werbekunden diesem Trend etwas entgegensetzen – sei es durch den Einsatz alternativer Suchmaschinen, durch bewusste Klicks auf organische Treffer oder durch den Aufbau eigener, unabhängiger Plattformen.

Bildquellen:

- Bildschirmfoto-2025-09-30-um-19.09.57_800x500: google screenshot

Fußnoten:

- https://www.boersenblatt.net/news/verlage-news/menschliche-kreativitaet-wird-verdraengt-werden-343325 (zurück)

- https://www.rosepartner.de/blog/urheberrechtsverletzung-durch-ki-training.html (zurück)

- https://em360tech.com/tech-articles/cnet-quietly-replaced-its-writers-chatgpt-and-no-one-noticed (zurück)

- https://www.wgbh.org/news/local/2025-03-11/local-gannett-owned-websites-are-using-ai-to-help-write-articles (zurück)

- https://www.livescience.com/technology/artificial-intelligence/ai-models-trained-on-ai-generated-data-could-spiral-into-unintelligible-nonsense-scientists-warn (zurück)

- https://theweek.com/tech/ai-cannibalization-model-collapse (zurück)

- https://www.livescience.com/technology/artificial-intelligence/ai-slop-is-on-the-rise-what-does-it-mean-for-how-we-use-the-internet (zurück)